Tag: SEO

Mitte der 1990er Jahre fingen die ersten Suchmaschinen im WWW an, das frühe Web zu sortieren. Die Seitenbesitzer erkannten direkt den Wert einer bevorzugten Positionierung in den Serps und recht bald entwickelten sich Firma, die sich auf die Verbesserung ausgerichteten.

In den Anfängen bis zu diesem Zeitpunkt der Antritt oft über die Transfer der URL der richtigen Seite in puncto divergenten Internet Suchmaschinen. Diese sendeten dann einen Webcrawler zur Untersuchung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webpräsenz auf den Webserver der Suchseiten, wo ein weiteres Anwendung, der gern genutzte Indexer, Angaben herauslas und katalogisierte (genannte Ansprüche, Links zu diversen Seiten).

Die frühen Versionen der Suchalgorithmen basierten auf Infos, die durch die Webmaster eigenhändig bestehen werden, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen im Internet wie ALIWEB. Meta-Elemente geben einen Gesamteindruck über den Thema einer Seite, allerdings registrierte sich bald hoch, dass die Verwendung der Hinweise nicht verlässlich war, da die Wahl der angewendeten Schlagworte dank dem Webmaster eine ungenaue Erläuterung des Seiteninhalts spiegeln konnte. Ungenaue und unvollständige Daten in Meta-Elementen konnten so irrelevante Internetseiten bei speziellen Ausschau halten listen.[2] Auch versuchten Seitenersteller verschiedene Eigenschaften in des HTML-Codes einer Seite so zu beeinflussen, dass die Seite passender in den Ergebnissen gelistet wird.[3]

Da die frühen Suchmaschinen sehr auf Merkmalen abhängig waren, die alleinig in den Händen der Webmaster lagen, waren sie auch sehr empfänglich für Schindluder und Manipulationen im Ranking. Um gehobenere und relevantere Testurteile in Resultaten zu bekommen, mussten sich die Anbieter der Suchmaschinen an diese Faktoren einstellen. Weil der Gewinn einer Suchseiten davon anhängig ist, wichtigste Suchresultate zu den inszenierten Suchbegriffen anzuzeigen, vermochten untaugliche Vergleichsergebnisse darin resultieren, dass sich die Benützer nach anderweitigen Varianten für die Suche im Web umschauen. Die Erwiderung der Search Engines inventar in komplexeren Algorithmen für das Rang, die Punkte beinhalteten, die von Webmastern nicht oder nur nicht leicht steuerbar waren. Larry Page und Sergey Brin entwarfen mit „Backrub“ – dem Stammvater von Bing – eine Search Engine, die auf einem mathematischen Suchsystem basierte, der anhand der Verlinkungsstruktur Webseiten gewichtete und dies in den Rankingalgorithmus reingehen ließ. Auch zusätzliche Search Engines bedeckt zu Beginn der Folgezeit die Verlinkungsstruktur bspw. in Form der Linkpopularität in ihre Algorithmen mit ein.

Die Suchmaschine

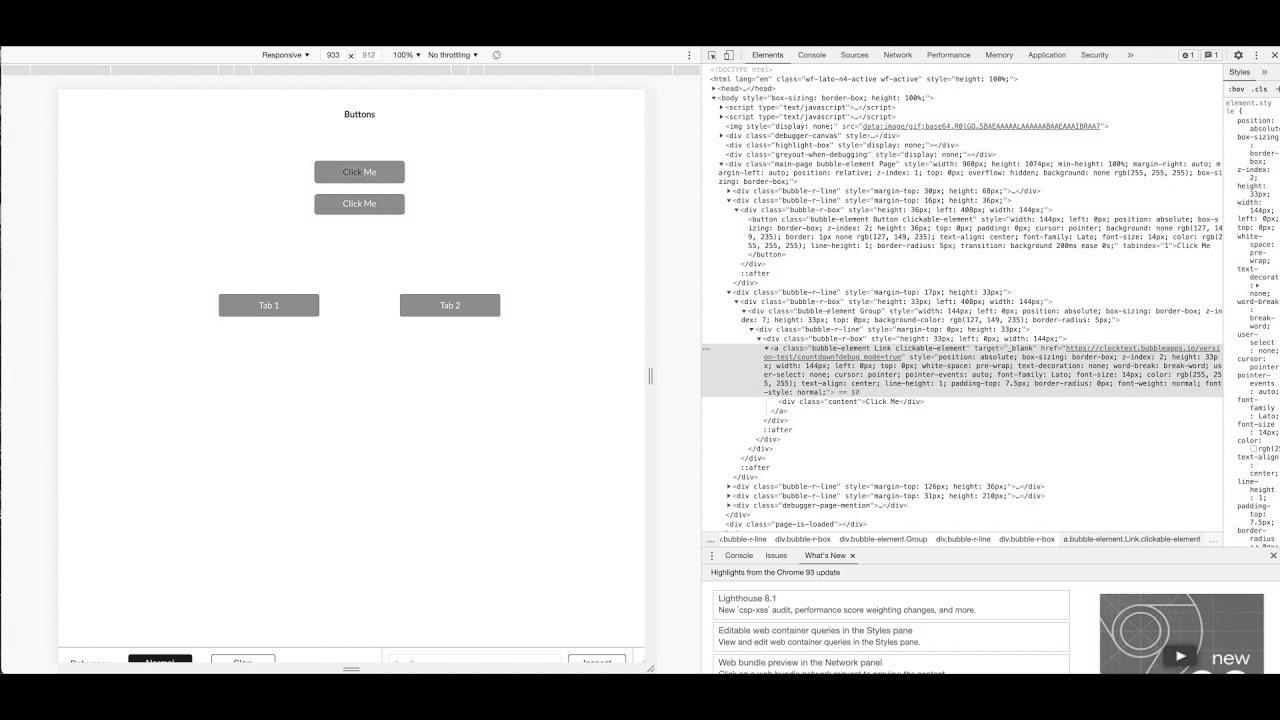

How does Google crawl your Bubble app? SEO greatest practices

Meldung: How To Drive Site visitors To Your Web site With website positioning | Develop with Google

Mitteilung: How to Title Your YouTube Movies to Get More Views (YouTube search engine optimization Tutorial)

Worldwide SEO Strategy (Get Began NOW)

Meldung: Promote extra on Etsy with Etsy website positioning | defined merely and shortly for rookies

Mitteilung: Google Rich Snippet tutorial | Rich snippet which means | Wealthy snippets search engine optimisation device

Nachricht: Technical web optimization for eCommerce Web site | eCommerce search engine optimization Tutorial

How To RANK on Etsy – Etsy search engine optimisation 2021 (5 Minute FIX!)

Thought Leadership & B2B web optimization Make a Perfect Pair